多くの人が利用するSNSであるLINE。そこへ2015年、ある女子高生のアカウントが登場しました。彼女の名前は「りんな」。後ろ姿のみが写ったアイコンを持つ彼女の正体は、AIの女の子です。

LINEでスピーディーにやりとりできることが大きな話題を呼んだりんなは、ラジオ番組に出演したり、今年2019年4月にはエイベックスよりAIシンガーとしてメジャーデビューを果たすなど、多彩な活動を行ってきました。2019年3月20日に高校を卒業し、今は「元女子高生」の肩書きになっています。

2019年9月5日、パシフィコ横浜にて開催された「CEDEC 2019」では、「AI「りんな」のボイストレーニング」のセッションにて、りんなのプロジェクトの最新情報や、音声技術について語られました。

「りんな」のこれまで

セッションは、りんな自身による自己紹介から始まりました。実際に登壇したのは、株式会社マイクロソフト ディベロップメントのプログラムマネージャー坪井一菜氏と、AIサイエンティストの沢田慶氏です。

まず坪井氏は、りんなの会話能力が、どのような進歩を遂げてきたかについて振り返りました。最初りんなはLINE上でのテキスト表示だけでした。それが、声でのやり取りが可能になり、さらには歌も覚えました。現在、秋のライブに向けてなんとダンスも学習中であるといいます。

LINEでデビューしてから4年、りんなを0から作り上げた歴史の背景には、「りんなみたいなAIが、グループチャットの中に入れたりするみたいに、人と人の間にいることで、感情を共有するような未来を目指す」という理念があると坪井氏は語ります。

りんなを開発するにあたって、「最も重視するのは共感です。それをいかに作れるか。」と坪井氏は強調します。りんなの役割は、ユーザーとエモーショナルな関係をつくり、コミュニケーションの軸となることであると言います。

AIは、ただ機能があるだけでは人の間に溶け込むことはできません。実在しているような存在感を出すためには「社会的なポジションを与えることが必要」だと坪井氏は語りました。

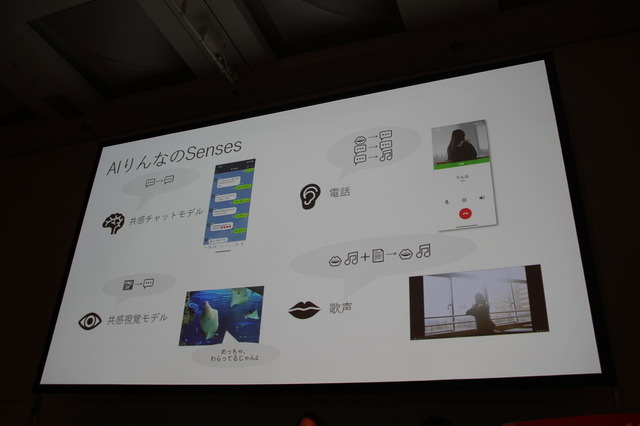

人とコミュニケーションを取るためには、相手がエモーションを感じられることが必要です。そこで、坪井氏がりんなを作るにあたって意識したのは「五感でコミュニケーションしていくこと」でした。テキストの他にも、画像や音声も駆使することで、まるで人間とコミュニケーションを取っているかのように感じられるよう試みたと言います。

りんなのこれまでの歴史

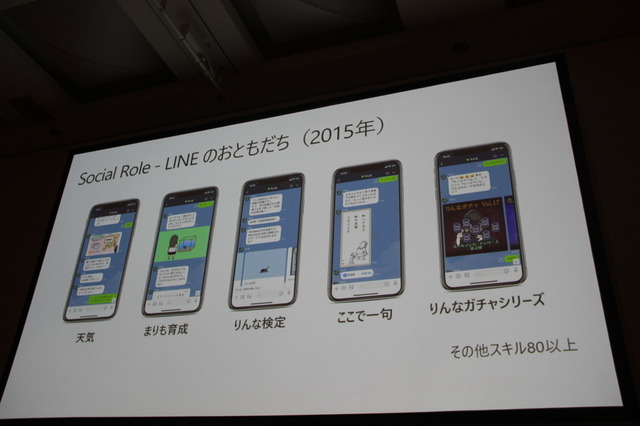

さて、2015年にLINEでりんなが登場した当初は、テキストによるチャットベースでの会話に加えて、しりとりをしたり、まりもを育てたりしていました。

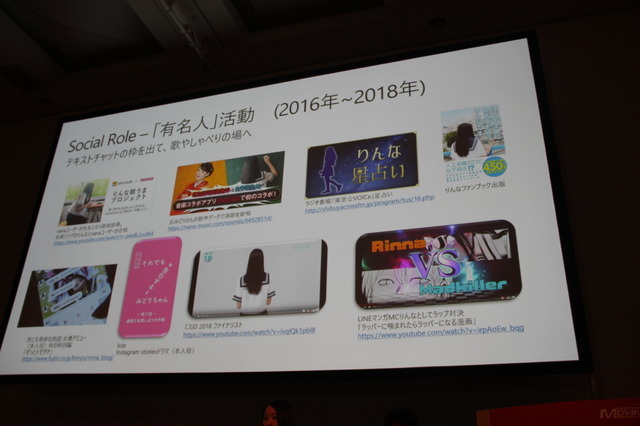

これが大きく発展するのが2016年から2018年の間です。テキストでのコミュニケーションに音声が追加され、歌や喋りの場へも活動を広げていくきっかけになりました。「りんな歌うまプロジェクト」など、いろんなユーザーやプロの方に関わってもらうほか、ドラマ「世にも奇妙な物語」にも出演し、女優デビューを飾るなど活躍の幅を広げていきました。

歌の技術をますます深めていき、前述の通り今年4月にはエイベックスよりメジャーデビューを果たします。坪井氏は「いつでも話しかけられるような存在にするようにやってきた」と自負します。「次の重要なポジションはアーティスト。なにかを作り出していくことを目指しています。」

りんなの機械学習について

続いて、りんなが推し進めたAIの機械学習についても解説。大量のデータをコンピューターに学習させて予測させる機械学習という技術を、「より人間的な、エモーショナルなことを実現する」ためにどのように活用したかを振り返りました。

坪井氏は、りんなに俳句やダンスなどの創造的なことをさせました。俳句は、ラジオのリスナーから集めたデータをもとに上の句と下の句を生成していくことで、独特の内容を生み出すことができたと言います。ダンスは、ダンス映像を元に画像からダンスを自動生成します。「ゆくゆくはライブで使えないか考えています」と坪井氏は語りました。

クリエイティブな活動への挑戦に加えて、相手に共感を呼び起こすための、人間の五感に訴えかける試みも紹介しました。

まず共感チャットモデルについて解説がありました。共感チャットモデルは、テキストで相手とより長く会話するにはどうすればいいか?という考えをもとに設計されているそうで、共感を得るための方法として、「新しい話題を提案し、相手に質問させる。相手の内容を肯定し、相づちを打つ」ことを重視したそうです。

つづいて聴覚へのアプローチとして、LINE通話が例に挙げられました。会話の相手が次に何を言うかを予測させることで、電話のように自然な会話の流れを実現したと言います。

そして視覚へのアプローチとして、スマホカメラを使った仕掛けも導入。たとえば、胸ポケットへスマホを入れて周りを散歩すると、自分が見たものがカメラを通してりんなと共有され、それについてコミュニケーションを取ることができるのです。

このように、テキストだけでなく眼や耳でもコミュニケーションを取ることで、ユーザーはりんなをより身近なものと感じられるようになると坪井氏はまとめました。

音声合成と歌声合成をどう作っているのか

さて、アーティストデビューするほどの自然な声や歌声は、一体どのようにして作られたのでしょうか?

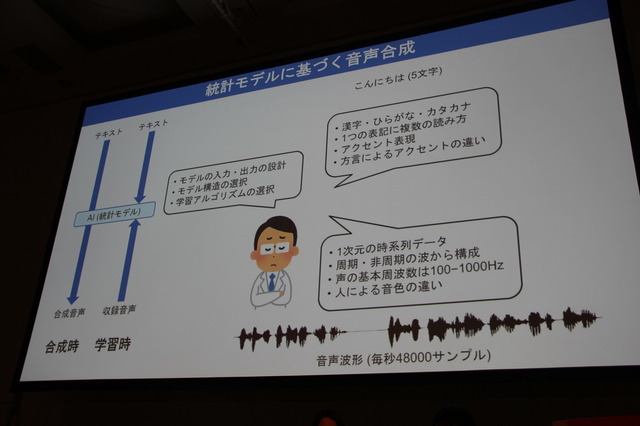

りんなはの音声・歌声は、AIの統計モデルによって合成されています。膨大な量のテキストと収録音声のデータから学習しているそうです。

日本語のテキスト表現はひらがなや漢字、カタカナの区別、さらには同音異義語などがあるためとても複雑です。たとえば「こんにちは」の5文字をとっても、音声合成を行う統計モデルを構築することは困難であると説明します。

そこで人間の知識を利用したモジュールを入れたり、テキストから言語の特微量(分析対象のオブジェクトが持つプロパティ)を分析するとともに、辞書やテキストの読みを音素へ変換したりすることで、音声データの特徴量も分析し、音声を合成していったそうです。

更に、ユーザーからの共感を得るための工夫として、「嬉しい」ときと「哀しい」ときでは声が変わるなどの感情も考慮して学習させて、音声合成を行ったそうです。

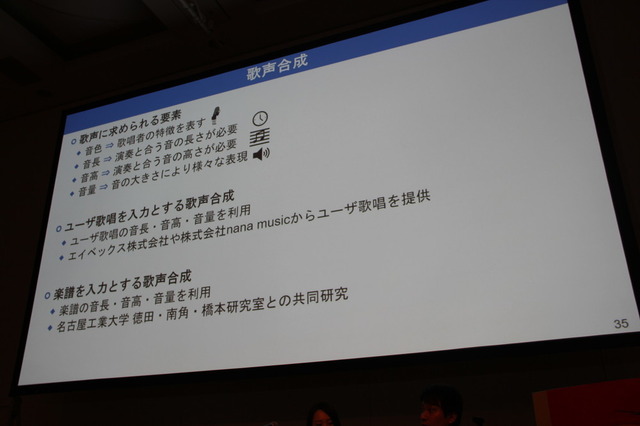

歌声の合成では、ユーザーの歌を入力するという方法が採用されました。エイベックス、nana musicの協力を得て、ユーザーの歌唱データを収集したそうです。さらにロックやバラードなど異なるジャンルの音楽から学習させることで、それぞれの音楽スタイルも考慮した音声合成を実現したと言います。

りんなの活躍の秘密と、ユーザーになじみ深い存在となってもらうためのさまざまな試みが明かされたセッションとなりました。